Berri onak baliabide gutxiko hizkuntzentzat!

Ixa taldean aurre-entrenatutako hizkuntz eredu elebakarra eta eleaniztuna biak ala biak oso erabilgarriak dira euskararen prozesamenduko zereginetan! Euskaraz egindako galderak euskaraz automatikoki erantzuteko sistema batean adibidez.

Nahiz eta ingelesezkoa baino 500 aldiz txikiagoa den corpus batekin eta 80 aldiz txikiagoa den Euskal Wikipediarekin sortu ditugun, gure hizkuntza-eredu berri hauek emaitza onak eman dituzte.

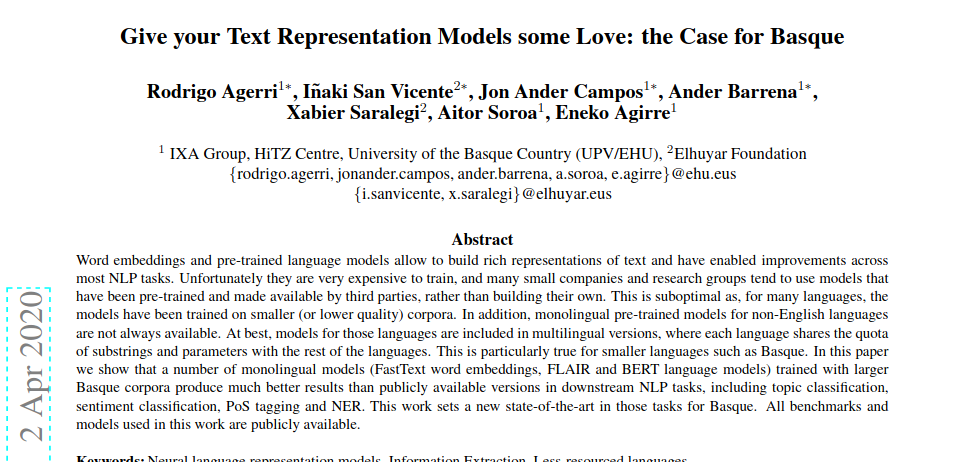

Hitz-bektoreek (word embedding-ak) eta aurrez entrenatutako hizkuntza-ereduek testuen errepresentazio aberatsak eraikitzeko aukera ematen dute, eta, horri esker, hobekuntzak egin ahal izan dira Hizkuntzaren Prozesamenduko ataza gehienetan. Zoritxarrez, errepresentazio horiek oso garestiak dira entrenatzeko, eta enpresa txiki eta ikerketa-talde askok eurenak eraiki beharrean, Googlek aurrez entrenatutako eta eskura jarritako ereduak baino ez dituzte erabiltzen. Hori ez da biderik onena, hizkuntza askotan ereduak enpresa txikiagoetan (edo kalitate txikiagokoetan) entrenatu baitira. Gainera, ingelesa ez diren hizkuntzetarako beti ez daude erabilgarri aurrez entrenatutako eredu elebakarrak. Kasurik onenean, hizkuntza horietako ereduak bertsio eleaniztunetan sartzen dira, eta hizkuntza bakoitzak gainerako hizkuntzekin partekatzen ditu tamaina eta parametroen zati bat. Hori egia da, bereziki, hizkuntza txikienetarako, hala nola euskararako.

Joan den apirilean Ixa Taldean erakutsi genuen euskarazko corpus handiekin (on-line egunkarietatik arakatuak) trebatutako zenbait eredu elebakarrek (FastText word embeddings, FLAIR eta BERT hizkuntza-ereduak) emaitza askoz hobeak eman zituztela Hizkuntzaren Prozesamenduko zereginetan, publikoki eskuragarri zeuden bertsioek baino. Besteak beste, emaitza hobeak lortu ziren gai-sailkapenean, sentimenduen analisian, baita PoS eta NER etiketatzean ere. Lan hori “Give your Text Representation Models some Love: the Case for Basque” izeneko artikuluan aurkeztu genuen. Hona hemen esperimentu horretan erabilitako Corpusaren osaketa:

| Iturria | Testu mota | Milioi token |

|---|---|---|

| Euskal Wikipedia | Entziklopedia | 35M |

| Berria egunkaria | Albisteak | 81M |

| EiTB | Albisteak | 28M |

| Argia aldizkaria | Albisteak | 16M |

| Herri aldizkariak | Albisteak | 224.6M |

Kontuan izan ingeleserako BERT hizkuntza-eredu originala Google Books corpus erabiliz entrenatu zela. 155 mila milioi hitz ditu iamerikako ingelesez, eta 34 mila milioi hitz ingeles brikanikoz. Ingelesezko corpusa euskarazkoa baino 500 aldiz handiagoa da.

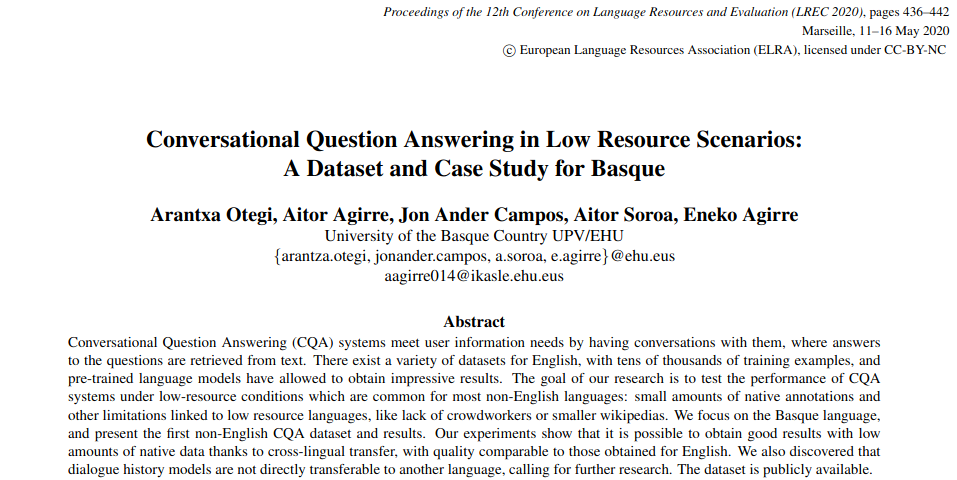

Orain, irailean, IXAmBERT argitaratu dugu, ingeleserako, gaztelaniarako eta euskararako aurrez prestatutako hizkuntza-eredu eleaniztuna. Eta arrakastaz erabili dugu euskarazko elkarrizketetan galderak erantzuteko sistema batean. Transferentzia-esperimentu horiek Googleren mBERT eredu ofizialarekin egin litezke ere, baina, Googleren ereduan hizkuntza asko direnez, euskara ez dago oso ondo ordezkatuta. Ingelesa, gaztelania eta euskara soilik dituen eredu eleaniztun berri hori sortzeko, apirilean aurkeztutako ereduaren konfigurazio bera erabili dugu. Euskal eredu sortzeko corpus elabkar bera erabili dugu berriz ere, eta gainera Ingeles Wikipedia eta espainierazkoa gehitu ditugu, hurrenez hurren, 2.5 G eta 650M tokenekin. Wikipedia horien tamainak euskarazkoa baino 80 eta 20 aldiz handiagoa dira.

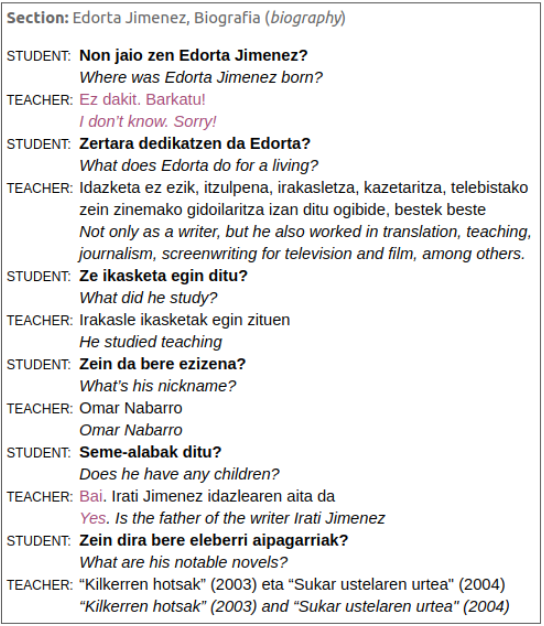

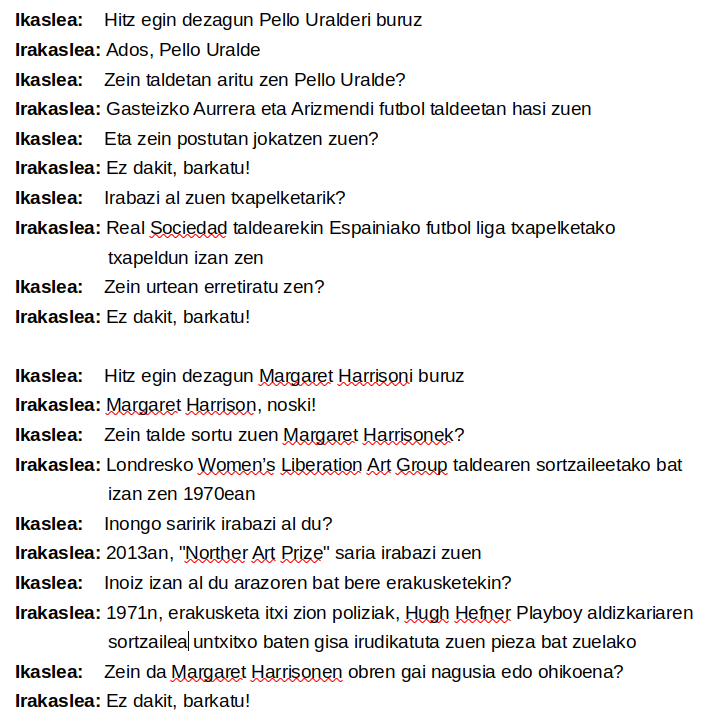

Berri ona zera da, eredu hori arrakastaz erabili dugula ingelesezko testuetan dagoen ezagutza euskarara transferitzeko, elkarrizketa bidezko galdera-/erantzun-sistema baten bidez. Artikulu honetan azaldu dugu: Conversational Question Answering in Low Resource Scenarios: A Dataset and Case Study for Basque. IXAmBERT izeneko gure hizkuntza-eredu berria erabiliz mBERT eredu generikoarekin baino hobeto egin zen ingelesaren ezagutza euskarara transferitzea. Galderak euskaraz egin, informazioa ingelesez, espainieraz eta euskarazko wikipedietan bilatu eta erantzuna euskaraz eman. Taula honetan ikus daiteke zenbatekoa da hobekuntza:

| Eredua | Zero-shot | Transfer learning |

|---|---|---|

| Baseline | 28.7 | 28.7 |

| mBERT | 31.5 | 37.4 |

| IXAmBERT | 38.9 | 41.2 |

| mBERT + history | 33.3 | 28.7 |

| IXAmBERT + history | 40.7 | 40.0 |

Taula horretan, Elkarrizketa Bidezko Galderak Erantzuteko (CQA, Conversational Question Anwering) euskarazko sistema baten emaitzak agertzen dira. Zero-shot-ek esan nahi du eredua fine-tuned dagoela QuaC, CQA datu-multzo ingelesa erabiliz. Transfer Learning konfigurazioan, eredua lehenengo aldiz QuaC-n zehazten da, eta gero euskal CQA datu-multzo batean.

Lan hauek koxka bat gorago ezartzen dute artearen egoera euskararako zeregin horietan.

Lan honetan erabilitako datuak eta eredu guztiak eskuragarri daude publikoki: https://huggingface.co/ixa-ehu/ixambert-base-cased

Iruzkinak (1)